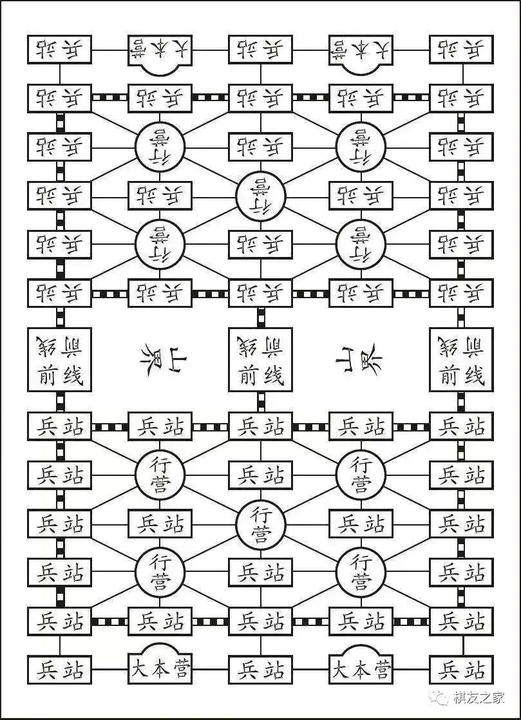

개요 軍旗(군기)라는 중국 보드 게임이 있습니다. 상대방의 깃발을 뺏는 전략 보드게임으로 상당히 재밌게 했던 기억이 있습니다. 해당 게임을 크로스 플랫폼으로 적절히 번역해서 개발하는것이 목표 요구사항 정리 일반 2인 FlagWar 게임만 구현 기물 세팅 구현 (로컬 캐싱기능만) simple 매칭 시스템 구현 (매칭룰 없음 FIFO) 게임 플레이 관련 구현 게임 resume을 염두한 설계 기능적 확장성 고려 인프라 확장성 및 가용성 고려 반응성 고려 핵심기능만 우선 구현 (추후 기능 추가개발) 게임 룰 정의 보드와 기물 1. 보드 5 X 12 게임판 기물을 배치할 수 있는 위치는 총 60개 이며, 위치는 포인트로 지칭한다. 총 3종류의 포인트가 있다. 기물이 움직이는 경로가 있으며, 경로는 총 2가지 있다..