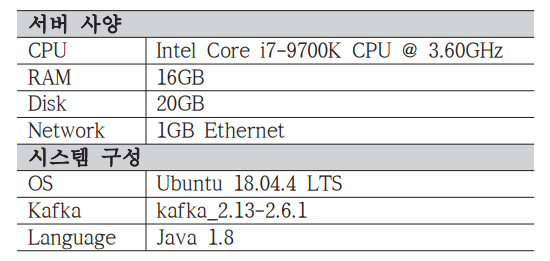

개요 - 데이터 파이프라인 생성 시 반복 작업을 줄이고 효율적인 전송을 이루기 위한 애플리케이션 - 반복작업에 대해서 매번 Producer, Consumer 애플리케이션의 배포/운영해야 하는 비효율 보완 - Connect 를 이용하면 특정한 작업 형태를 템플릿으로 만들어 놓은 Connector 를 실행함으로써 반복작업을 줄일 수 있음. - Kafka 브로커와 별도의 클러스터를 구성하며 Connector 가 실행되는 환경을 제공 장단점 장점 단점 관리 용이 모니터링 가능 개발 생산성 최적화 및 유지보수되는 pre-build connector 시스템 복잡성 증가 보안 문제 가능성 증가 (타 시스템 연동 때문) 제한된 기능 Confluent Platform 소개 Confluent Platform은 여러 소스 ..